Mô hình Segment Anything Model thực hiện một nhiệm vụ với tên gọi "phân đoạn", chính là nền tảng cho thị giác máy tính sử dụng để xác định sự vật và hiểu thế giới xung quanh. Ngoài việc phát hành mô hình AI mới, Meta cũng đang cung cấp bộ dữ liệu đào tạo về mô hình mới cho các nhà nghiên cứu bên ngoài.

Cuốn sách “The Language Instinct” của Steven Pinker xuất bản năm 1994 đã viết “Bài học chính rút ra sau 35 năm nghiên cứu về trí tuệ nhân tạo AI là bài toán tưởng khó thì thường dễ giải, còn bài toán vốn tưởng dễ thì lại khó”. Điều này tương tự nghịch lý Moravec, và tính thực tế của nó vẫn đúng dù 30 năm trôi qua. Các mô hình ngôn ngữ nổi tiếng như GPT-4 với khả năng tạo ra văn bản tương tự như lời nói của con người trong vài giây ngắn ngủi, trong khi đó các robot phải vật lộn để nhặt các khối có hình dạng kỳ lạ và đặt chúng vào đúng vị trí - một nhiệm vụ cơ bản cho trẻ nhỏ chơi để giải trí hằng ngày.

Chức năng của AI mới nhà Meta là phân khúc hình ảnh, một danh mục nghe có vẻ khá dễ dàng nhưng gặp khó về mặt kỹ thuật. Con người có thể nhìn vào bàn làm việc của họ và ngay lập tức biết đâu là máy tính, đâu là điện thoại, đâu là một đống giấy và đâu là khăn giấy bị vò nát. Nhưng đối với các máy tính xử lý hình ảnh 2D (kể cả video cũng chỉ là một loạt hình ảnh 2D), mọi thứ trên chỉ là một loạt các điểm ảnh pixel với các giá trị khác nhau, và chúng chẳng bao giờ biết phạm vi mặt bàn dừng lại ở đâu và hình ảnh khăn giấy bắt đầu từ đâu.

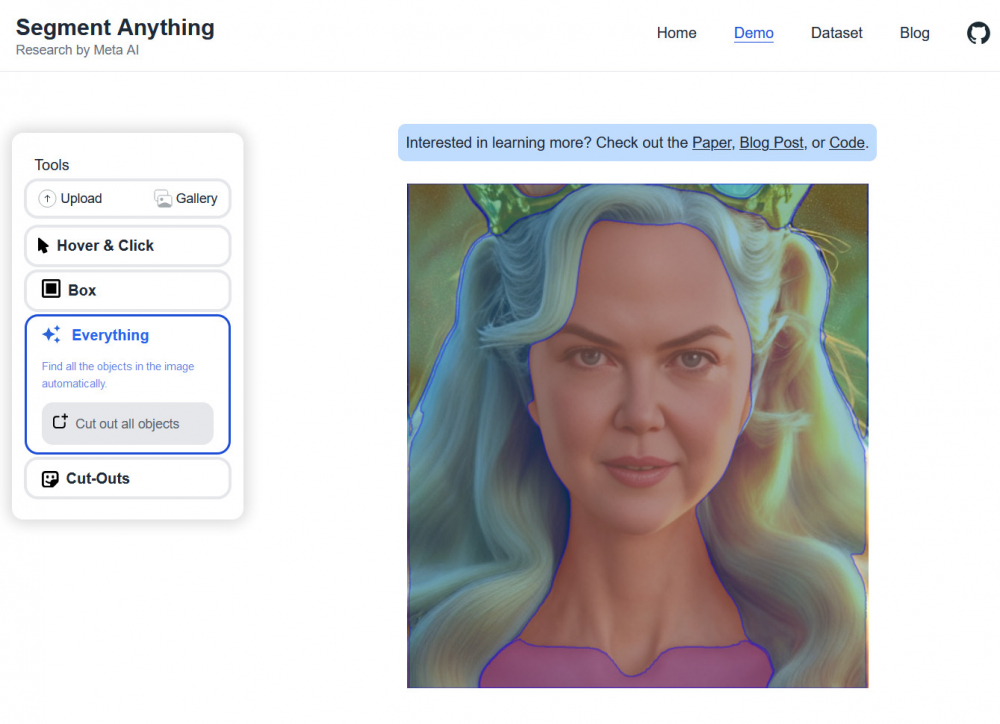

SAM AI mới của Meta được tạo ra để giải quyết vấn đề này theo cách tổng quát, thay vì sử dụng một mô hình được thiết kế riêng của một vật như khuôn mặt hay khẩu súng để xác định vật đó. “SAM AI được học một khái niệm chung về đối tượng và nó có thể tạo ra mặt nạ cho bất kỳ đối tượng nào trong bất kỳ hình ảnh hoặc video nào, thậm chí bao gồm các đối tượng và loại hình ảnh SAM AI chưa được thấy trong quá trình đào tạo”, các nhà nghiên cứu chia sẻ.

Nói cách khác, AI không những có thể nhận ra các đối tượng được dạy, mà còn có thể đoán các đối tượng khác nhau. SAM không cần phải trưng ra hàng trăm chiếc khăn giấy được vò nát khác nhau để phân biệt một chiếc trên bàn làm việc của bạn, nó chỉ cần hiểu biết tổng quát về mọi thứ trên đó là đủ.

Bạn có thể trải nghiệm SAM trong trình duyệt của Meta ngay bây giờ với hình ảnh của riêng bạn. SAM có thể tạo phân đoạn cho bất kỳ đối tượng nào bạn chọn bằng cách nhấp vào nó bằng con trỏ chuột hoặc vẽ một hộp xung quanh nó. Nó cũng có thể chỉ tạo mặt nạ cho mọi đối tượng mà nó phát hiện trong ảnh. Theo các nhà nghiên cứu, SAM cũng có thể nhận lệnh phân tích bằng văn bản, nhưng tính năng này vẫn chưa được Meta phát hành.

Mặc dù hiện tại có vô vàn hình ảnh và video trên thế giới mạng Internet, nhưng dữ liệu phân đoạn chất lượng cao như vậy lại rất hiếm và phù hợp với các công việc đặc thù. Để có được công nghệ SAM AI, Meta đã phải phát triển một cơ sở dữ liệu đào tạo mới, đó là bộ dữ liệu Segment Anything 1-Billion (SA-1B). Bộ dữ liệu mới chứa khoảng 11 triệu hình ảnh được cấp phép và hơn 1,1 tỷ hình ảnh phân đoạn “có chất lượng cao và đa dạng, và một số thậm chí có chất lượng tương đương với hình ảnh từ các bộ dữ liệu thủ công, nhỏ hơn nhiều trước đây”. Meta sẽ phát hành công nghệ mới cho các nhà nghiên cứu khác để tăng phạm vi ứng dụng của công nghệ.

Meta có những kế hoạch lớn cho chương trình phân khúc của mình. Thị giác máy tính nói chung vẫn là một vấn đề chưa được giải quyết trong trí tuệ nhân tạo và robot. Meta cho biết họ sẽ phát triển SAM AI có khả năng xác định các vật dụng hàng ngày thông qua kính thực tế tăng cường (AR). Một dự án khác của công ty với tên gọi Ego4D cũng có kế hoạch giải quyết vấn đề tương tự thông qua một lăng kính khác. Cả hai công nghệ này dự kiến sẽ trở thành những thay đổi lớn trong làng công nghệ.

SAM AI có tiềm năng trở thành công cụ hỗ trợ hữu ích trong ngành công nghiệp và nghiên cứu. Meta đề xuất sử dụng nó để đếm số lượng tổng thể, hoặc các nhà sinh vật học có thể theo dõi tế bào dưới kính hiển vi.